Traducció de l’article en anglès i tot l’estament en anglès amb entitats signants

La societat civil demana a la UE que protegeixi els drets de les persones en les negociacions del «triòleg» de la Llei d’IA

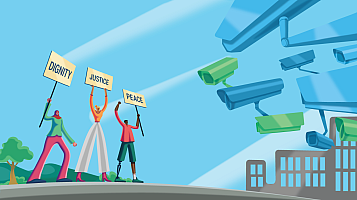

A mesura que les institucions de la UE inicien reunions decisives sobre la Llei d’Intel·ligència Artificial (IA), una àmplia coalició de la societat civil les insta a prioritzar les persones i els drets fonamentals en aquesta legislació històrica.

150 organitzacions de la societat civil demanen al Parlament Europeu, a la Comissió Europea i al Consell de la UE que posin en primer lloc les persones i els seus drets fonamentals a la Llei d’IA mentre les institucions de la UE procedeixen a les negociacions de «triòleg». Aquestes reunions decisives determinaran la legislació final i fins a quin punt centra els drets humans i les preocupacions de les persones que podrien veure’s afectades per sistemes d’IA «riscosos».

Els sistemes d’IA ja estan tenint un impacte de gran abast a les nostres vides. Cada cop s’utilitzen més per supervisar-nos i identificar-nos als espais públics, predir la nostra probabilitat de criminalitat, redirigir la policia i el control de la immigració cap a zones ja supervigilades, facilitar les violacions del dret a demanar asil, predir les nostres emocions i categoritzar-nos. . També s’utilitzen per prendre decisions crucials sobre nosaltres, per exemple, qui accedeix als sistemes de benestar.

Sense una regulació adequada, això agreujarà els danys socials existents de la vigilància massiva, la discriminació estructural i el poder centralitzat de les grans empreses tecnològiques.

La Llei d’IA és una oportunitat crucial per regular aquesta tecnologia i per prioritzar els drets de les persones sobre els beneficis. Mitjançant aquesta legislació, la UE ha de garantir que el desenvolupament i l’ús de la IA siguin responsables, siguin públicament transparents i que les persones tinguin poder per desafiar els danys:

Potenciar les persones afectades mantenint un marc de responsabilitat, transparència, accessibilitat i reparació

Això inclou exigir una avaluació de l’impacte dels drets fonamentals abans de desplegar sistemes d’IA d’alt risc, el registre de sistemes d’alt risc en una base de dades pública, requisits d’accessibilitat horitzontals i integrats per a tots els sistemes d’IA, el dret a presentar queixes quan un sistema d’IA vulnera els drets de les persones., i el dret a la representació i els drets a recursos efectius.

Limitar la vigilància perjudicial i discriminatòria per part de les autoritats de seguretat nacional, cossos de seguretat i migracions

Quan els sistemes d’IA s’utilitzen per a l’aplicació de la llei, la seguretat i el control de la migració, hi ha un risc encara més gran de danys i violacions dels drets fonamentals, especialment per a les comunitats ja marginades. Cal que hi hagi línies vermelles clares per a aquest ús per evitar danys. Això inclou la prohibició de tot tipus d’identificació biomètrica remota, sistemes de control predictiu, avaluacions de riscos individuals i sistemes analítics predictius en contextos migratoris.

Feu retrocedir el lobby de Big Tech i elimineu les llacunes que soscaven la regulació

Perquè la Llei d’IA s’apliqui amb eficàcia, els negociadors han de recular els esforços de pressió de Big Tech per soscavar la regulació. Això és especialment important quan es tracta de la classificació de riscos dels sistemes d’IA. Aquesta classificació ha de ser objectiva i no ha de deixar espai perquè els desenvolupadors d’IA puguin autodeterminar si els seus sistemes són prou «significatius» per ser classificats com d’alt risc i requereixen control legal. Les empreses tecnològiques, amb els seus incentius per obtenir beneficis, sempre voldran subclassificar els seus propis sistemes d’IA.

Redactat per: European Digital Rights, Access Now, Algorithm Watch, Amnistia Internacional, Bits of Freedom, Electronic Frontier Norway (EFN), European Centre for Not-for-Profit Law, (ECNL), European Disability Forum, Fair Trials, Homo Digitalis, Consell Irlandès per a les Llibertats Civils (ICCL), Fundació Panoptykon, Plataforma per a la Cooperació Internacional sobre els Drets dels Migrants Indocumentats (PICUM).